Trong thời đại dữ liệu trở thành “vũ khí chiến lược” của doanh nghiệp, kỹ năng phân tích thôi là chưa đủ – bạn còn cần những công cụ mạnh mẽ để khai thác, xử lý và trực quan hóa thông tin hiệu quả. Dưới đây là 7 công cụ phân tích và lưu trữ dữ liệu lớn hàng đầu mà bất kỳ Data Analyst nào cũng nên nắm vững.

Công cụ phân tích big data là gì?

Công cụ phân tích Big Data là nền tảng chuyên biệt giúp doanh nghiệp xử lý khối lượng dữ liệu lớn khổng lồ, phát sinh liên tục từ nhiều nguồn khác nhau. Không giống công cụ phân tích truyền thống, chúng có khả năng thu thập, lưu trữ, xử lý và trực quan hóa dữ liệu với tốc độ cao. Nhờ vậy, doanh nghiệp có thể khai thác được giá trị thực sự từ dữ liệu. Đây là nền tảng quan trọng để đưa ra quyết định chiến lược chính xác.

Bản chất của dữ liệu lớn nằm ở ba yếu tố chính: dung lượng khổng lồ, tốc độ phát sinh nhanh và sự đa dạng về định dạng. Chính vì vậy, các công cụ phân tích Big Data được thiết kế để hoạt động ổn định trong môi trường phức tạp, có khả năng xử lý dữ liệu theo thời gian thực. Điều này giúp doanh nghiệp nắm bắt xu hướng, tối ưu vận hành và nâng cao lợi thế cạnh tranh.

→ Có thể bạn quan tâm: Phân tích dữ liệu lớn là gì?

Vai trò quan trọng của các công cụ phân tích dữ liệu lớn

Việc thành thạo các công cụ phân tích dữ liệu mang lại nhiều lợi ích rõ rệt:

- Tăng tốc xử lý dữ liệu: Các công cụ giúp tự động hóa bước thu thập – xử lý – phân tích, tiết kiệm thời gian so với thao tác thủ công.

- Tăng độ chính xác: Giảm rủi ro sai sót khi xử lý khối lượng dữ liệu lớn, đồng thời giúp chuẩn hóa kết quả phân tích.

- Hỗ trợ ra quyết định nhanh: Với dashboard và báo cáo trực quan, nhà quản lý dễ dàng tiếp cận insight và phản ứng linh hoạt với biến động thị trường.

- Mở rộng năng lực cá nhân: Đối với Data Analyst, thành thạo các công cụ này là “tấm vé” để nâng cao năng lực nghề nghiệp và cơ hội thăng tiến.

Có thể bạn quan tâm:

- 6 lợi ích của big data trong kinh doanh thời đại số

- 4 kỹ thuật phân tích dữ liệu lớn giúp đưa ra quyết định kinh doanh chính xác hơn

7 công cụ phân tích và lưu trữ dữ liệu lớn được sử dụng rộng rãi trong ngành

1. Tableau – Trực quan hóa dữ liệu dễ dàng, không cần code

Tableau được xem là một trong những nền tảng trực quan hóa dữ liệu mạnh mẽ nhất hiện nay. Công cụ này giúp người dùng biến những tập dữ liệu phức tạp thành biểu đồ, bảng điều khiển (dashboard) trực quan, dễ hiểu, phù hợp để chia sẻ với các bộ phận khác trong doanh nghiệp mà không cần kỹ năng lập trình.

Tableau đặc biệt được ưa chuộng bởi các công ty lớn như Cisco Systems, LinkedIn và Lenovo. Người dùng có thể kết nối Tableau với kho dữ liệu nội bộ hoặc các nguồn dữ liệu bên ngoài, sau đó tạo các báo cáo trực quan theo thời gian thực.

Bên cạnh bản trả phí (70 USD/tháng), Tableau còn có bản Tableau Public miễn phí, hỗ trợ kết nối với bảng tính hoặc Google Sheets. Đây là lựa chọn phổ biến với những người mới bắt đầu học công cụ phân tích dữ liệu.

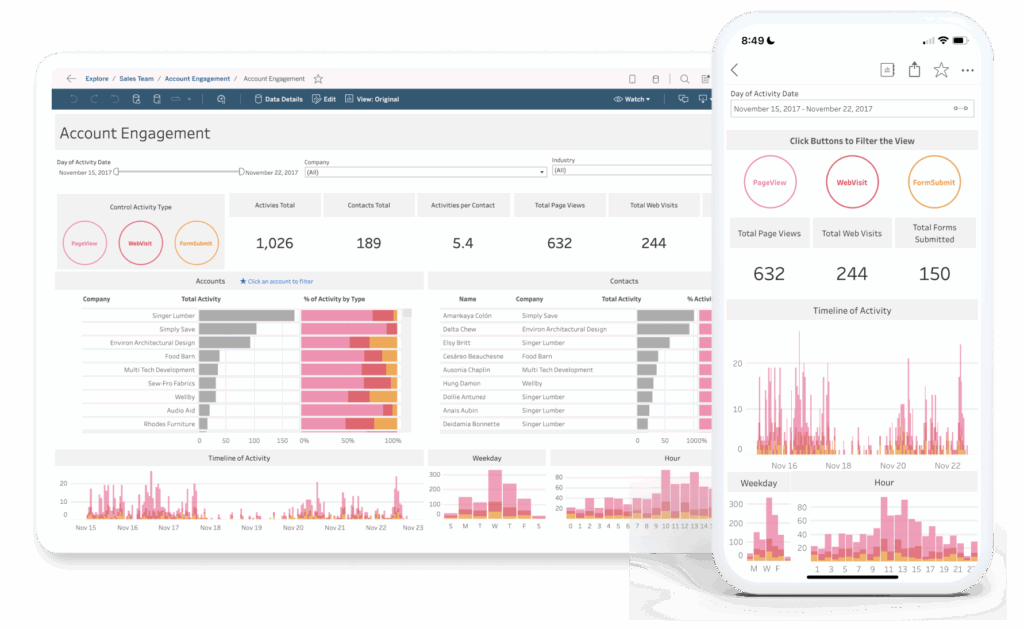

2. Microsoft Power BI – Kết nối dữ liệu linh hoạt, tạo báo cáo chuyên nghiệp

Power BI là nền tảng Business Intelligence (BI) trên nền tảng đám mây, giúp người dùng thu thập dữ liệu từ nhiều nguồn khác nhau (bao gồm Microsoft Excel), xử lý, phân tích và xây dựng các báo cáo tương tác.

Power BI cho phép Data Analyst tạo mô hình dữ liệu, biểu đồ, bảng tổng hợp để chia sẻ nội bộ, giúp nhà quản lý dễ dàng nắm bắt thông tin và ra quyết định nhanh chóng. Một số tập đoàn lớn như Hitachi Solutions, Adobe hay Toyota Motor Corporation đều đang sử dụng công cụ này.

Người dùng có thể bắt đầu với Power BI Desktop miễn phí để thiết kế báo cáo, sau đó chia sẻ qua Power BI Service. Gói Pro có giá khoảng 9,99 USD/người/tháng, phù hợp với doanh nghiệp muốn mở rộng quy mô.

3. SAS – Phân tích thống kê chuyên sâu

SAS (Statistical Analysis Software) là bộ phần mềm phân tích thống kê được sử dụng rộng rãi trong doanh nghiệp, đặc biệt trong các ngành tài chính, bảo hiểm, y tế và sản xuất. Công cụ này giúp Data Analyst trích xuất dữ liệu, phát hiện mẫu, phân tích xu hướng để đưa ra dự báo đáng tin cậy.

SAS được nhiều tổ chức tin dùng như Honda, Kia và Office Depot. Điểm mạnh của SAS là giao diện thân thiện, không yêu cầu nhiều kiến thức lập trình ngoài một số thao tác cơ bản với SQL.

SAS cung cấp các khóa học phân tích big data miễn phí và trả phí, cũng như bản dùng thử cho các doanh nghiệp muốn trải nghiệm khả năng phân tích dữ liệu nâng cao.

4. Erwin Data Modeler – Mô hình hóa dữ liệu hiệu quả

Erwin là công cụ chuyên dụng để mô hình hóa cơ sở dữ liệu – một bước quan trọng trong quy trình phân tích dữ liệu. Với Erwin, Data Analyst có thể vẽ sơ đồ dữ liệu, mô tả cấu trúc, reverse-engineer cơ sở dữ liệu hiện có để hiểu rõ mối quan hệ giữa các bảng và dữ liệu bên trong.

Nhiều công ty như Fidelity International và CenturyLink đang sử dụng Erwin để chuẩn hóa mô hình dữ liệu, giúp việc quản trị và truy xuất thông tin nhanh chóng hơn. Erwin cung cấp khóa học online, đào tạo trực tiếp và bản demo miễn phí để doanh nghiệp đánh giá trước khi mua bản quyền.

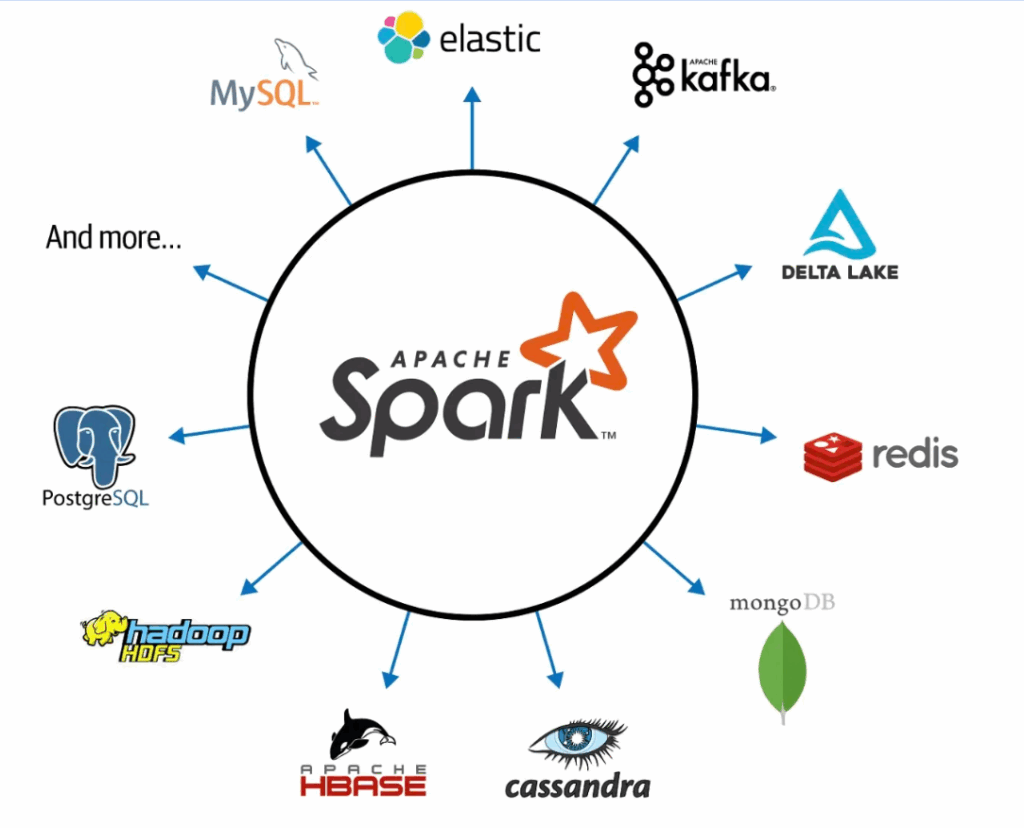

5. Apache Spark – Xử lý dữ liệu lớn nhanh chóng

Apache Spark là công cụ xử lý dữ liệu mã nguồn mở, có khả năng phân tích khối lượng dữ liệu khổng lồ với tốc độ cao. Spark cho phép Data Analyst thực hiện các truy vấn, xử lý dữ liệu theo thời gian thực lẫn dữ liệu lưu trữ, giúp khai thác insight nhanh chóng.

Các “ông lớn” như eBay, Yahoo và Amazon đều sử dụng Spark để tối ưu quy trình phân tích dữ liệu lớn. Công cụ này đặc biệt phù hợp khi cần xử lý dữ liệu phi cấu trúc từ các nguồn như phản hồi khách hàng, đánh giá sản phẩm hay dữ liệu mạng xã hội.

Spark là công cụ miễn phí và có sẵn nhiều tài liệu hướng dẫn, giúp người dùng nhanh chóng làm quen và ứng dụng trong thực tế.

6. SQL Server Integration Services – Công cụ ETL mạnh mẽ

SQL Server Integration Services (SSIS) là công cụ ETL (Extract – Transform – Load) giúp Data Analyst trích xuất, chuyển đổi và tải dữ liệu từ nhiều nguồn khác nhau như Excel, Hadoop hay các cơ sở dữ liệu SQL. SSIS hỗ trợ thiết kế workflow, tự động hóa quy trình trích xuất dữ liệu, rất hữu ích trong các dự án có dữ liệu phức tạp hoặc cần làm sạch trước khi phân tích.

Công cụ này được tích hợp sẵn trong gói SQL Server của Microsoft, đồng thời có thể mua rời cho người dùng nền tảng đám mây Microsoft Azure. Microsoft cũng cung cấp nhiều tài liệu học và hướng dẫn miễn phí để người mới dễ dàng tiếp cận việc phân tích dữ liệu lớn.

7. RapidMiner – Phân tích dự đoán và khai thác dữ liệu

RapidMiner là nền tảng phân tích dữ liệu tích hợp, cho phép thực hiện đồng thời nhiều tác vụ từ data mining, machine learning đến phân tích dự đoán. Đây là lựa chọn phổ biến khi các dự án yêu cầu xử lý và lưu trữ dữ liệu lớn, phức tạp.

Nhiều doanh nghiệp như PayPal hay Domino’s Pizza đã ứng dụng RapidMiner để tối ưu chiến lược kinh doanh. Ví dụ, từ dữ liệu bán hàng lịch sử, công cụ này có thể hỗ trợ doanh nghiệp xác định phân khúc khách hàng tiềm năng và đề xuất cách tiếp cận phù hợp.

RapidMiner cung cấp bản dùng thử miễn phí, tài liệu học tập và nền tảng sử dụng trên trình duyệt hoặc cài đặt trực tiếp trên máy tính.

Phân tích và lưu trữ dữ liệu lớn đã trở thành chìa khóa giúp doanh nghiệp ra quyết định nhanh và chính xác hơn. Việc thành thạo các công cụ như Tableau, Power BI, SAS, Erwin, SSIS, Spark hay RapidMiner không chỉ giúp Data Analyst làm việc hiệu quả mà còn nâng cao giá trị bản thân trong tổ chức. Hiểu và làm chủ công cụ chính là bước khởi đầu để bạn trở thành một Data Analyst thực thụ.

Xem thêm:

- Công cụ nào được sử dụng để phân tích dữ liệu lớn (big data)?

- Đón đầu xu hướng phân tích dữ liệu và chuyển đổi số cho doanh nghiệp cùng khóa học BADT tại SOM AIT

- Ưu điểm và nhược điểm của big data là gì? Đi tìm mô hình xử lý big data phát huy ưu điểm, giảm bớt nhược điểm

- Các lĩnh vực ứng dụng big data như thế nào? 5 ví dụ về các ngành nghề ứng dụng dữ liệu lớn thành công.