Trong thời đại số, dữ liệu được xem là “dầu mỏ mới” giúp doanh nghiệp hiểu thị trường, hành vi khách hàng và ra quyết định chính xác hơn. Để khai thác hiệu quả “mỏ vàng” này, phân tích dữ liệu lớn (Big Data Analytics) trở thành công cụ không thể thiếu. Vậy phân tích dữ liệu lớn là gì và mang lại giá trị gì cho tổ chức? Hãy cùng tìm hiểu.

Phân tích dữ liệu lớn là gì?

Phân tích dữ liệu lớn (Big Data Analytics) là quá trình xử lý và phân tích có hệ thống khối lượng dữ liệu khổng lồ, phức tạp — hay còn gọi là big data — nhằm khai thác thông tin giá trị phục vụ ra quyết định.

Nguồn dữ liệu này không chỉ đến từ nội bộ mà còn từ nhiều kênh như cảm biến IoT, mạng xã hội, giao dịch tài chính và thiết bị thông minh. Quy mô và tốc độ tăng trưởng dữ liệu giúp tổ chức tận dụng dữ liệu như “tài sản chiến lược”, nắm bắt cơ hội và tối ưu vận hành.

Từ những năm 2000, sự phát triển mạnh mẽ của phần cứng và phần mềm đã giúp tổ chức có khả năng thu thập và xử lý khối lượng lớn dữ liệu. Cộng đồng mã nguồn mở sau đó đã phát triển nhiều khung xử lý dữ liệu phân tán giúp lưu trữ và xử lý dữ liệu hiệu quả trên mạng lưới máy tính.

Những công cụ phân tích big data này cho phép doanh nghiệp thực hiện:

- Mô hình dự báo: Kết hợp AI và thuật toán thống kê để dự đoán xu hướng.

- Phân tích thống kê: Khai phá dữ liệu, phát hiện mô hình và mối quan hệ ẩn.

- Phân tích giả định: Mô phỏng kịch bản “what-if” để dự đoán kết quả tiềm năng.

- Xử lý dữ liệu đa dạng: Bao gồm dữ liệu có cấu trúc, bán cấu trúc và phi cấu trúc.

Sự khác biệt giữa dữ liệu lớn và dữ liệu truyền thống

Điểm khác biệt cốt lõi giữa phân tích dữ liệu lớn và phân tích dữ liệu truyền thống nằm ở loại dữ liệu xử lý và công cụ phân tích. Dữ liệu truyền thống chủ yếu là dữ liệu có cấu trúc, được lưu trong các hệ quản trị cơ sở dữ liệu quan hệ, dễ tổ chức và truy xuất. Phân tích truyền thống thường sử dụng các phương pháp thống kê cơ bản và ngôn ngữ truy vấn SQL để xử lý.

Ngược lại, phân tích big data làm việc với khối lượng dữ liệu khổng lồ, đa dạng định dạng — có cấu trúc, bán cấu trúc và phi cấu trúc. Sự phức tạp này đòi hỏi các kỹ thuật phân tích tiên tiến hơn, như machine learning và khai phá dữ liệu, nhằm trích xuất thông tin từ các tập dữ liệu lớn. Ngoài ra, hệ thống xử lý phân tán như Hadoop thường được sử dụng để quản lý hiệu quả khối lượng dữ liệu khổng lồ này.

3 Loại dữ liệu lớn

1. Dữ liệu có cấu trúc (Structured): Được tổ chức rõ ràng, dễ tìm kiếm và thường lưu trong cơ sở dữ liệu quan hệ. Ví dụ: tên khách hàng, giao dịch tài chính, thông tin nhân sự. Ưu điểm là dễ nhập liệu và truy vấn (SQL).

2. Dữ liệu phi cấu trúc (Unstructured): Không theo mô hình định sẵn, chiếm phần lớn dữ liệu hiện nay: văn bản, email, video, âm thanh, log IoT… Phân tích loại dữ liệu này đòi hỏi NLP, machine learning và công cụ phân tích nâng cao.

3. Dữ liệu bán cấu trúc (Semi-structured): Nằm giữa hai loại trên, có thẻ hoặc cấu trúc nhẹ giúp dễ phân tích hơn. Ví dụ: JSON, XML, email, cơ sở dữ liệu NoSQL.

Bốn phương pháp phân tích big data chính

Có 4 phương pháp phân tích dữ liệu lớn thường thấy:

1. Phân tích mô tả (Descriptive analytics): Tập trung trả lời câu hỏi “Điều gì đã xảy ra?”. Phương pháp này giúp tóm tắt và mô tả dữ liệu trong quá khứ để hiểu bức tranh tổng thể.

2. Phân tích chẩn đoán (Diagnostic analytics): Giải đáp câu hỏi “Tại sao điều đó xảy ra?”. Bằng cách đi sâu vào dữ liệu, phương pháp này xác định nguyên nhân, mô hình và xu hướng ẩn phía sau các kết quả từ phân tích mô tả.

3. Phân tích dự báo (Predictive analytics): Trả lời câu hỏi “Điều gì có thể xảy ra?”. Sử dụng dữ liệu lịch sử, mô hình thống kê và machine learning để dự đoán xu hướng tương lai.

4. Phân tích khuyến nghị (Prescriptive analytics): Tập trung vào “Nên làm gì tiếp theo?”. Dựa trên kết quả của các phân tích trước đó, phương pháp này đưa ra khuyến nghị hành động tối ưu cho tương lai.

Xem thêm:

- Công cụ nào được sử dụng để phân tích dữ liệu lớn (big data)?

- 4 kỹ thuật phân tích dữ liệu lớn giúp đưa ra quyết định kinh doanh

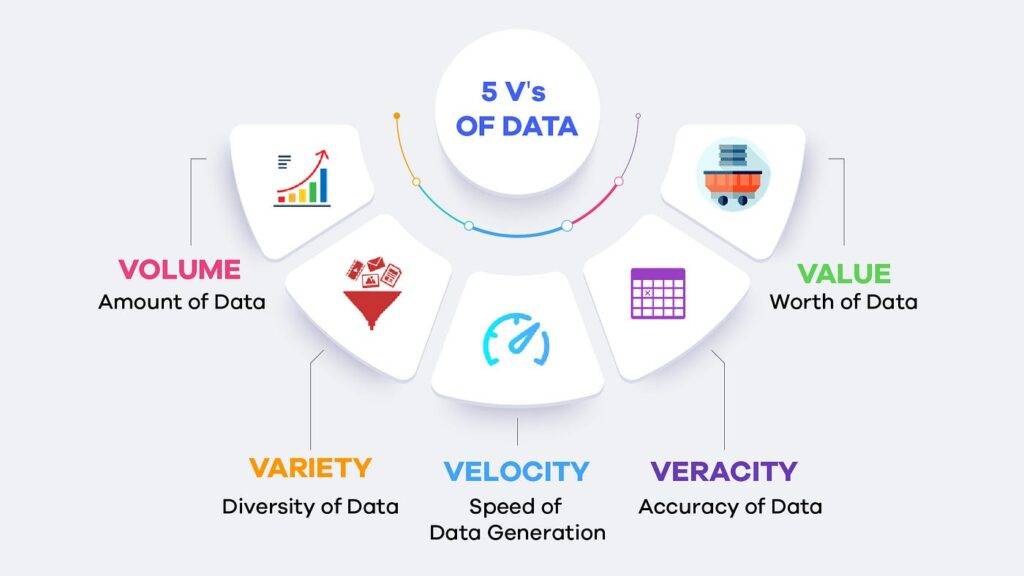

Năm yếu tố “V” của phân tích dữ liệu lớn trong kinh doanh

Năm yếu tố sau thể hiện những thách thức và cơ hội cốt lõi trong công nghệ dữ liệu lớn:

1. Volume (Khối lượng)

Khối lượng dữ liệu khổng lồ từ mạng xã hội, thiết bị IoT, giao dịch… vượt xa khả năng của các hệ thống lưu trữ truyền thống. Công nghệ dữ liệu lớn và giải pháp lưu trữ đám mây giúp doanh nghiệp quản lý dữ liệu hiệu quả, tránh lãng phí tài nguyên.

2. Velocity (Tốc độ)

Dữ liệu được tạo ra với tốc độ chưa từng có — từ cập nhật mạng xã hội theo thời gian thực đến giao dịch tài chính tức thời. Điều này đòi hỏi hệ thống xử lý mạnh để thu thập và phân tích dữ liệu lớn nhanh chóng. Các công nghệ xử lý luồng và xử lý trong bộ nhớ giúp đáp ứng yêu cầu này.

3. Variety (Đa dạng)

Dữ liệu ngày nay có nhiều định dạng: có cấu trúc, bán cấu trúc, văn bản, hình ảnh, video… từ nhiều nguồn khác nhau. Do đó, doanh nghiệp cần hệ thống quản lý linh hoạt như NoSQL, data lake và schema-on-read để tích hợp và phân tích toàn diện.

4. Veracity (Độ tin cậy)

Chất lượng và tính chính xác của dữ liệu quyết định hiệu quả ra quyết định. Veracity liên quan đến việc phát hiện nhiễu, bất thường và đảm bảo tính toàn vẹn. Các kỹ thuật làm sạch, xác thực và kiểm chứng dữ liệu giúp nâng cao độ tin cậy.

5. Value (Giá trị)

Mục tiêu cuối cùng của phân tích dữ liệu lớn trong kinh doanh là chuyển đổi dữ liệu thành giá trị chiến lược. Nhờ phân tích nâng cao, machine learning và AI, doanh nghiệp có thể khai thác thông tin hữu ích, tối ưu quyết định và mở ra cơ hội tăng trưởng.

Quy trình triển khai phân tích dữ liệu lớn

Đội ngũ chuyên gia dữ liệu thường làm việc trên data lakehouse — kết hợp hiệu suất của kho dữ liệu (data warehouse) với tính linh hoạt của hồ dữ liệu (data lake). Quy trình chuyển dữ liệu thô thành thông tin giá trị gồm 4 bước chính:

Bước 1 – Thu thập dữ liệu (Collect): Tập hợp dữ liệu có cấu trúc và phi cấu trúc từ nhiều nguồn: đám mây, ứng dụng di động, cảm biến IoT… Sau đó tích hợp vào kho trung tâm để quản lý tập trung và dễ truy xuất.

Bước 2 – Xử lý dữ liệu (Process): Dữ liệu được trích xuất – chuyển đổi – nạp (ETL) vào hệ thống lưu trữ. Giai đoạn này có thể dùng xử lý theo lô (batch) cho dữ liệu lớn hoặc xử lý luồng (stream) cho dữ liệu thời gian thực.

Bước 3 – Làm sạch dữ liệu (Clean): Đảm bảo chất lượng bằng cách định dạng lại, loại bỏ trùng lặp và dữ liệu không liên quan. Dữ liệu sạch giúp kết quả phân tích chính xác và đáng tin cậy.

Bước 4 – Phân tích dữ liệu (Analyze): Ứng dụng các kỹ thuật tiên tiến như khai phá dữ liệu, phân tích dự báo, machine learning, deep learning để phát hiện xu hướng và mô hình ẩn. Chẳng hạn, Deep learning dùng mạng nơ-ron nhiều tầng để học từ dữ liệu phức tạp như hình ảnh, âm thanh, văn bản; xử lý ngôn ngữ tự nhiên (NLP) giúp trích xuất thông tin từ khối lượng lớn văn bản phi cấu trúc.

Lợi ích khi ứng dụng công nghệ dữ liệu lớn

Phân tích dữ liệu lớn trong kinh doanh mang lại nhiều giá trị giúp doanh nghiệp ra quyết định hiệu quả và phát triển bền vững:

- Ra quyết định chính xác hơn: Dữ liệu được phân tích theo thời gian thực giúp nhà quản lý nắm rõ xu hướng thị trường, hành vi khách hàng và rủi ro tiềm ẩn để đưa ra quyết định nhanh, đúng hướng.

- Tối ưu hóa vận hành: Big data giúp phát hiện điểm yếu trong quy trình, giảm lãng phí và chi phí, đồng thời nâng cao hiệu suất làm việc.

- Hiểu khách hàng sâu hơn: Phân tích hành vi trên nhiều kênh giúp doanh nghiệp cá nhân hóa trải nghiệm, cải thiện dịch vụ và tăng sự hài lòng.

- Phát hiện rủi ro và cơ hội sớm: Công nghệ dữ liệu lớn cho phép nhận diện bất thường và dự đoán xu hướng, giúp doanh nghiệp phản ứng linh hoạt và đi trước đối thủ.

- Thúc đẩy đổi mới: Khi dữ liệu được khai thác hiệu quả, doanh nghiệp có thể tạo ra sản phẩm mới, cải thiện chiến lược kinh doanh và tăng trưởng nhanh hơn.

→ Xem thêm: 6 lợi ích của big data trong kinh doanh thời đại số

Cơ hội nghề nghiệp trong lĩnh vực Big Data

Sự bùng nổ dữ liệu kéo theo nhu cầu lớn về nhân sự chuyên môn:

- Data Scientist – Phân tích dữ liệu phức tạp, áp dụng AI/ML để tìm insight.

- Data Analyst – Trích xuất và diễn giải dữ liệu để hỗ trợ ra quyết định.

- Data Engineer – Xây dựng và quản lý hạ tầng xử lý dữ liệu.

- Machine Learning Engineer – Phát triển thuật toán học máy để dự đoán và tự động hóa.

- Business Intelligence Analyst – Tạo báo cáo, dashboard hỗ trợ quản trị.

- Data Visualization Specialist – Thiết kế trực quan dữ liệu giúp dễ hiểu.

- Data Architect – Xây dựng kiến trúc dữ liệu toàn diện cho tổ chức.

Tóm lại, phân tích dữ liệu lớn không chỉ là công cụ hỗ trợ mà còn là đòn bẩy chiến lược giúp doanh nghiệp ra quyết định chính xác, tối ưu vận hành và tạo lợi thế cạnh tranh. Khi dữ liệu được khai thác hiệu quả, tổ chức có thể nắm bắt cơ hội nhanh hơn, phát triển bền vững hơn và mở ra nhiều cơ hội nghề nghiệp giá trị trong kỷ nguyên số.

Xem thêm: